کاربرد و نقش فایل robot.txt

در مبحث سئو، عناوین و تکنیک های مختلفی وجود دارد که هر کدام از آن ها کاربرد های متفاوتی دارند. یکی از فایل هایی که در امر سئو بسیار تاثیر گذار است، فایل...

برای سفارش آنلاین سئوی پیشرفته کافیست در سایت ثبت نام نموده و سفارش آنلاین سئوی پیشرفته ثبت نمائید تا بلافاصله فاکتور دریافت نمائید و سپس تصمیم گیری فرمائید.

این فایل به عنوان صادر کننده مجوز به ربات ها فعالیت میکند. زمانی که یک سایت بخواهد توسط ربات ها مورد بررسی قرار گیرد، ابتدا فایل robot.txt فراخوانی و بررسی میشود. در این فایل، دستوراتی اجرا میشود که به ربات اجازه دسترسی به صفحات خاصی را میدهد. یعنی ربات ها، قادر به بررسی هر صفحه ای نیستند و دسترسی آن ها توسط این فایل داده میشود. یکی از مهم ترین ربات هایی که در حال حاضر وجود دارد، ربات های جستجوگر گوگل است.

لزوم داشتن فایل robot.txt

از مهم ترین ملزوماتی که صاحب هر وبسایتی باید داشته باشد، ابزار کنترلگری است که ورود ربات ها را کنترل کند. البته این کنترل کردن نیز بی دلیل نیست و دلایل مربوط به خود را دارد. بگذارید برایتان مثالی بزنیم. هیچکدام از صفحات وب سایت، با هم از لحاظ ارزش و اهمیت، برابر نیستد و تفاوت هایی دارند.

دسترسی های ربات ها به صفحات وب سایت

حتی وب مستران، علاقه ای ندارند که پنل مدیریتی آن ها در دسترس کاربران قرار بگیرد. یا اگر یک سایت پر بازدیدی دارید، ممکن است نگران این باشید که ظرفیت سایت شما از جمله پهنای باند آن، برای بازدید ربات ها مصرف شود. در این صورت، فایل robot.txt به کمک شما خواهد آمد.

این فایل باعث میشود تا دسترسی های ربات ها به صفحات وب سایتمان محدود شود یا توسط آن دسترسی های مخصوص خود را داشته باشد. برای مثال اگر یک ربات بخواهد روزی پانصد بار از صفحه سایت ما بازدید کند، توسط فایل robot.txt مانع این کار میشویم و تعداد دفعات بازدید آن را کاهش میدهیم

آیا فایل robot میتواند نتایج جستجو را پاک کند؟

یکی از کار هایی که تا به امروز برای جلوگیری از نمایش یک صفحه از وب سایت خود انجام میدادید، استفاده از دستور No index بود. این دستور باعث میشد تا صفحه مورد نظر وب سایت، از دید و دسترس ربات ها دور باشد. ولی یکی از مشکلات این دستور این است که صفحه مد نظر ما را از نتایج جستجو گوگل، پنهان و حذف نمیکند و همچنان در نتایج باقی میماند.

مخفی سازی نتایج جستجو

اخیرا گوگل اعلام کرده است که به هیچ عنوان از فایل robot.txt جهت حذف نتایج جستجو استفاده نشود. البته فعلا این فایل برای خارج کردن فایل های مدیا از نتایج جستجو میتوان استفاده کرد. ولی برای صفحات وب، راه خوبی نیست. در ادامه به معرفی بهترین راه های جایگزین برای مخفی سازی نتایج جستجو و حذف آن ها از گوگل را معرفی خواهیم کرد. پس با ما همراه باشید.

دلیل اهمیت فایل robot.txt

این فایل اهمیت هایی دارد که در ادامه به آن ها اشاره میکنیم.

1- جلوگیری از مصرف بیشتر ترافیک توسط ربات ها

برای این که ربات ها از ترافیک وب سایت، بیش از اندازه استفاده نکنند، فایل robot.txt میتواند این کار را انجام دهد. زیرا عده ای از ارائه دهنده های سرور، پهنای باند کمی دارند و اگر از این اشغال سازی بیش از حد جلوگیری نشود، ممکن است با مشکل رو به رو شویم. این مشکل میتواند کاهش سرعت وب سایت یا عدم بارگذاری بعضی از صفحات باشد.

2- جلوگیری از نمایش بعضی از صفحات و فایل ها در جستجوی گوگل

البته این موضوع را خاطر نشان شویم که هیچ تضمینی بر روی این نتیجه وجود ندارد که فایل ها یا صفحاتی که توسط فایل robot.txt محدود به بازدید توسط ربات ها شده اند، حتما عمل خواهد کرد. ممکن است که همان صفحات، توسط ربات ها دوباره ایندکس شوند. به همین دلیل گفتیم که برای جلوگیری از نمایش صفحات در نتایج جستجو بهتر است از دستور No index استفاده شود.

اگر وب سایت شما به صورت دستی طراحی شده است، با قرار دادن این دستور در قسمت کد های head میتوانید این کار را انجام دهید. یا اگر توسط وردپرس، وب سایت خود را طراحی کرده اید میتوانید توسط افزونه های مخصوص، نسبت به مخفی سازی صفحات مورد نظر خود اقدام کنید.

3- مدیریت ربات خزنده

زمانی که وب سایت شما دارای صفحات زیادی باشد، ربات ها زمان کافی برای خزیدن در بین صفحات را نخواهند داشت. به همین دلیل ممکن است که رتبه وب سایت شما در گوگل کاهش یابد. یک اصطلاحی به نام Crawl Budget وجود دارد که در آن ربات گوگل در طی مدت یک روز، صفحاتی را بررسی است. این ربات میتواند آمار زیادی از وب سایت شما به دست آورد که باز هم توسط فایل robot.txt میتوانید آن را محدود کنید.

فایل robot.txt چه محدودیت هایی دارد؟

زمانی که شما دستور العملی را در داخل فایل robot.txt استفاده میکنید، ممکن است که توسط عده ای از ربات های موتور جستجو، اطاعت نشوند. زیرا ساختار آن ها با یکدیگر متفاوت است. به عنوان مثال ممکن است که این دستورات توسط ربات های موتور گوگل اجرا شوند ولی به احتمال زیاد این دستورات در موتور های جستجوی دیگری مانند Bing اجرا نشوند.

نتایج در جستجوی گوگل ایندکس

مشکل دیگری که ممکن است برای ربات ها به هنگام اجرای این فایل، پیش بیاید این است که شاید بعضی از ربات ها، دستوراتی را نتوانند اجرا کنند. یا به عبارتی ممکن است قابل فهم برای ربات دیگری نباشد. یکی دیگر از محدودیت هایی که شامل حال فایل robot.txt میشود این است که ممکن است با وجود دستور عدم بررسی بعضی از صفحات توسط ربات ها، باز هم نتایجی پس از جستجو در گوگل ایندکس شوند. حتی اگر شما دستور No Index را در فایل robot استفاده کنید، باز هم نتایج در جستجوی گوگل ایندکس خواهند شد.

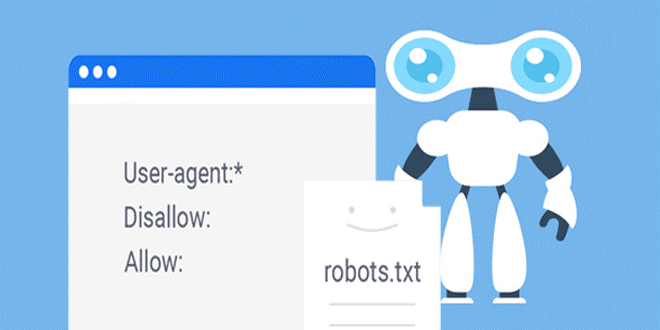

دستورات فایل robot.txt

به صورت کلی، 4 دستور در فایل robot.txt وجود دارد که در ادامه به آن ها اشاره خواهیم کرد.

-

1- دستور User-agent : این دستور، رباتی را مشخص میکند که دستورات برای آن نوشته شده است.

-

2- دستور Disallow : توسط این دستور، به ربات فهمانده میشود که قسمت هایی که ذکر شده، نباید بررسی شوند.

-

3- دستور Allow : این دستور به ربات اجازه دسترسی به بخش های مورد نظر را میدهد.

-

4- دستور Sitemap : توسط این دستور، آدرس فایل نقشه سایت به ربات ها ارائه میشود

در این نوشته کردیم تا کاربرد فایل robot.txt را برایتان شرح دهیم و نحوه کارکرد آن را نیز برایتان آشکار کنیم. امیدواریم که این مطلب برایتان مفید واقع شده باشد.

برای سفارش آنلاین سئوی پیشرفته کافیست در سایت ثبت نام نموده و سفارش آنلاین سئوی پیشرفته ثبت نمائید تا بلافاصله فاکتور دریافت نمائید و سپس تصمیم گیری فرمائید.

لیست نظرات

x اولین نظر را شما ثبت نمائید